L'information, les analyses et les conseils

pour gérer votre portefeuille d’actions.

L'information, les analyses et les conseils

pour gérer votre portefeuille d’actions.

hiboo, une équipe professionnelle qui vous accompagne sur les marchés financiers.

hiboo, une équipe professionnelle qui vous accompagne sur les marchés financiers.

Plus de 100 sociétés sélectionnées et analysées pour vous

NOTRE PROMESSE

La performance de votre portefeuille dans la durée en misant sur la performance des entreprises.

Optimisez votre portefeuille grâce à nos analyses boursières

Notre mission : L’analyse financière professionnelle mise au service des investisseurs particuliers.

Notre mission : donner aux investisseurs particuliers des armes équivalentes à celles des investisseurs professionnels.

Un outil d’analyse

Hiboo mesure sur plus de 60 000 valeurs dans le monde si celles-ci sont décotées ou non, volatiles ou non, et si elles offrent un potentiel de valorisation intéressant pour les années à venir.

Des conseils pour investir

Nos analyses sur plus de 100 actions françaises et une sélection de leaders mondiaux en estiment la valeur (sécurité, rentabilité, résilience, etc) et le potentiel.

Des professionnels à vos côtés

Hiboo vous aide dans la gestion de votre portefeuille via des portefeuilles témoins (PEA, Compte-titre, Rendement), des flashs (articles sur les sociétés), des lives ou des entretiens téléphoniques avec notre équipe.

NOTRE PLATEFORME

Notre plateforme d’analyse boursière hiboo vous accompagne dans tous vos investissements.

hiboo a créé une plateforme à part entière pour ses abonnés. En constante évolution, notre site grandit avec vos remarques pour que notre outil soit adapté de la meilleure manière à vos attentes.

Simple d'utilisation

Une plateforme créée pour que n’importe qui puisse l’utiliser.

Visualiser les cours de plus 60 000 valeurs en 1 clic

Une barre de recherche toujours présente pour trouver LA société.

Accessible partout

Smartphones, tablettes, ordinateurs… hiboo reste le même.

NOTRE PLATEFORME

Notre plateforme d’analyse boursière hiboo vous accompagne dans tous vos investissements.

hiboo a créé une plateforme à part entière pour ses abonnés. En constante évolution, notre site grandit avec vos remarques pour que notre outil soit adapté de la meilleure manière à vos attentes.

Simple d'utilisation

Une plateforme créée pour que n’importe qui puisse l’utiliser.

Visualiser les cours de plus 60 000 valeurs en 1 clic

Une barre de recherche toujours présente pour trouver LA société.

Accessible partout

Smartphones, tablettes, ordinateurs… hiboo reste le même.

Découvrez gratuitement l’intégralité

de l’une de nos analyses !

L’équipe hiboo vous offre la possibilité de lire notre analyse de Publicis, entreprise spécialisée dans la publicité et le marketing, leader français et 3ème groupe mondial.

Découvrez gratuitement l’intégralité de l’une de nos analyses !

L’équipe hiboo vous offre la possibilité de lire notre analyse de Publicis, entreprise spécialisée dans la publicité et le marketing, leader français et 3ème groupe mondial.

QUESTIONS FRÉQUENTES

Vos questions sur la bourse et notre plateforme

hiboo est un outil qui vous permettra de sélectionner au mieux les valeurs sur lesquelles investir.

Oui. hiboo est une entreprise indépendante qui travaille avec plusieurs analystes financiers (seniors ou. juniors) financiers au quotidien.

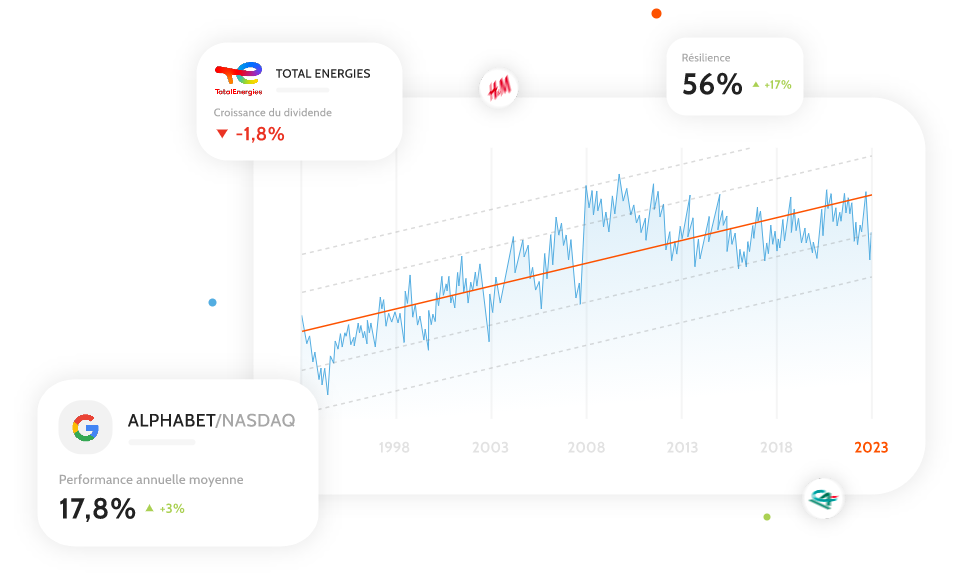

La droite de régression est ce qui représente le mieux la tendance à long terme d’un cours de bourse à partir de la distribution des différents points du cours sur le graphique. Elle établie la tendance d’un cours de bourse. Sur notre site, nous en proposons pour plus de 60 000 valeurs sur des indices (comme le CAC) et sur des actions (comme LVMH) du monde entier. Chez hiboo, la droite de régression est calculée à dividendes réinvestis.

hiboo propose aujourd’hui 3 portefeuilles virtuels : un PEA ; un Compte-titre et un Rendement.

Via des abonnements. Annuellement ou mensuellement, vous pourrez vous abonner à hiboo à partir de 18€/mois.

Pour découvrir nos abonnements, cliquez ici : https://site.hiboo.expert/abonnements/

QUESTIONS FRÉQUENTES

Vos questions sur la bourse et notre plateforme

À quoi sert Hiboo ?

hiboo est un outil qui vous permettra de sélectionner au mieux les valeurs sur lesquelles investir.

Vos analyses et conseils sont-ils rédigés par vous et seulement vous ?

Oui. hiboo est une entreprise indépendante qui travaille avec plusieurs analystes financiers (seniors ou. juniors) financiers au quotidien.

Une droite de régression, c’est quoi ?

La droite de régression est ce qui représente le mieux la tendance à long terme d’un cours de bourse à partir de la distribution des différents points du cours sur le graphique. Elle établie la tendance d’un cours de bourse. Sur notre site, nous en proposons pour plus de 60 000 valeurs sur des indices (comme le CAC) et sur des actions (comme LVMH) du monde entier. Chez hiboo, la droite de régression est calculée à dividendes réinvestis.

Quels types de portefeuilles boursiers proposez-vous ?

hiboo propose aujourd’hui 3 portefeuilles virtuels : un PEA ; un Compte-titre et un Rendement.

Comment s’abonner à Hiboo ?

Via des abonnements. Annuellement ou mensuellement, vous pourrez vous abonner à hiboo à partir de 18€/mois.

Pour découvrir nos abonnements, cliquez ici

À PROPOS D’HIBOO

Une équipe pour vous accompagner

Trois fondateurs, trois générations, trois univers. Guillaume, l’expérience de plus de 40 ans d’analyse financière et de gestion de fonds d’investissements Marie, après quelques années en finance de marché, le monde des starts ups avec sa deuxième aventure entrepreneuriale. Maxime gère le développement et la communication chez hiboo depuis 4 ans.

À PROPOS D’HIBOO

Une équipe pour vous accompagner

Trois fondateurs, trois générations, trois univers. Guillaume, l’expérience de plus de 40 ans d’analyse financière et de gestion de fonds d’investissements Marie, après quelques années en finance de marché, le monde des starts ups avec sa deuxième aventure entrepreneuriale. Maxime gère le développement et la communication chez hiboo depuis 4 ans.

C’est le nombre de personnes qui ont déjà testé hiboo, pourquoi pas vous ?